Choisir un modèle d’IA, le casse-tête des artistes (2/2)

Article publié le 03/10/2024

- #EXPERTISE

Temps de lecture : 9 min

MOTION – Bruno Ribeiro

Les effets du dataset

Malgré la prolifération des modèles d’intelligence artificielle générative, beaucoup d’artistes ont encore une vision réduite des outils sur le marché et leur impact. Après avoir abordé les enjeux des modèles propriétaires, libres et open source (lire l’article), ce deuxième volet dissèque un point essentiel des modèles : le dataset. Sa constitution et la nature des données ont des répercussions variées sur l’uniformisation des esthétiques, sur les impacts écologiques ou sur des questions relatives au droit d’auteur. Analyse appuyée de témoignages d’expert·es.

Avant d’entrer dans le vif du sujet, il est important de comprendre l’utilité d’un jeu de données et de revenir sur quelques aspects techniques. Un dataset est composé de données (chiffres, textes ou images) et sert à entraîner des algorithmes. Sa fonction principale est donc de fournir à l’algorithme une diversité d’exemples pour apprendre à reconnaître des motifs, prendre des décisions et faire des prédictions. En d’autres termes, le dataset est indispensable aux systèmes d’IA comme le sont les LLM conçus pour traiter et générer du texte (ChatGPT, Google Gemini, LLaMA ou Claude) ou les générateurs d’images (Midjourney, Stable Diffusion, DALL-E). Ces modèles qui permettent de générer des textes ou des images sont entraînés sur d’énormes quantités de données provenant de sites web ou de réseaux sociaux (la technique la plus connue est appelée web scraping), collectées avec le consentement – plus ou moins éclairé – des internautes. Concentrons-nous d’abord sur les données utilisées pour l’entraînement des LLM et les générateurs d’images.

Une mécanique d’uniformisation

Ces données, bien que conséquentes, restent génériques : elles forment en quelque sorte un grand scan d’Internet et peuvent conduire à une standardisation des réponses générées. Conceptuellement, “avec ces modèles basés sur le Big Data, on obtient une forme de photographie de l’inconscient collectif d’Internet. C’est intéressant, mais le moteur de la créativité repose sur la contrainte, par exemple sur un dataset limité” commente l’artiste Justine Emard qui a fait de l’IA le fil conducteur de son travail. À terme, ce dataset globalisé pourrait avoir un effet pervers : les jeux de données issus du web scraping ou du web crawling (technique d’indexation pour explorer automatiquement le Web) intègrent progressivement des contenus provenant des modèles d’IA générative, polluant ainsi les modèles existants. Cela provoquerait un effet de cannibalisation des esthétiques. Une hypothèse loin d’être vérifiée tant les LLM évoluent continuellement.

De même, la question des biais renforçant par exemple le racisme ou le sexisme se pose dans la constitution de ces datasets. Un aspect à ne pas négliger, mais qui mérite d’être approfondi. L’artiste Grégory Chatonsky partage justement son expertise dans un article publié sur son site web. “On critique dans l’induction statistique sa propension à mettre en avant certains points de vue (…) Qu’exige-t-on en échange ? Une absence de biais ? D’autres biais ? Une transparence et une lisibilité sans reste de ces biais ? Si l’on a tendance à transformer fantasmatiquement l’IA en un persona autonome doté d’une personnalité, il faut plutôt la considérer comme une nouvelle manière de naviguer et de consulter une bibliothèque.” Autrement dit, ne soyons ni aveuglé·e par subjectivité, ni naïf·ve dans ce désir d’objectivité et de neutralité. “La critique met de côté l’herméneutique historique propre à toute lecture et délègue encore plus aux automatismes de l’IA ce qui devrait constituer notre faculté de réflexivité. La critique, comme c’est souvent le cas, reproduit ce qu’elle croit contester. En mettant en scène la puissance de vérité de l’IA, elle l’institue.”

Créer un dataset sur-mesure

Certain·es artistes choisissent de constituer leurs propres datasets afin de préserver leur singularité, cultiver leur subjectivité. Ismaël Joffroy Chandoutis, artiste situé au croisement de l’art contemporain et du cinéma (lire l’article publié dans HACNUMedia) est spécialiste de l’IA et du deepfake. Il détaille plusieurs méthodes pour intégrer un jeu de données. Par exemple pour un LLM, il est possible de “créer son dataset, en collant des textes dans la fenêtre de chat. Dans ce cas, il faut respecter la limite de mots que le modèle peut traiter, c’est ce qu’on appelle le context length token. Si on a besoin de plus, on peut utiliser un système qui cherche des infos supplémentaires via une RAG (génération augmentée de récupération). Cela implique la constitution d’une base de données externe sur un serveur local ou en ligne.” Si les techniques de création de datasets diffèrent encore lorsqu’il s’agit de génération d’images, de vidéos ou de son, l’enjeu reste crucial dans tous les cas de figure.

L’artiste Bruno Ribeiro, auteur de plusieurs œuvres réalisées avec l’IA comme Polydactylie ou CELLULOD/D y voit une manière d’être “indépendant et unique. Mon œuvre MOTION (ndlr : présentée à Metahaus du 18 au 25 octobre 2024) qui est un hommage au cheval au galop d’Eadweard Muybridge est constituée à partir d’images d’autres films. Je voulais que ce soient des images que je connaissais, que j’avais choisies.” Alors que la machine permet de dépasser ce que l’œil ne peut voir, ici la subjectivité de l’artiste reste au centre de la démarche. Justine Emard partage sa réflexion lors de la création d’ Hyperphantasia. Pour cette œuvre, une IA en Machine Learning (autre qu’un LLM) a été entraînée à partir d’une base de données scientifique de la grotte Chauvet Pont-d’Arc, afin de fabriquer de nouvelles images. “Je ne voulais pas entrer dans un fantasme de la préhistoire. Je voulais rester dans une forme d’abstraction. J’ai donc travaillé avec l’archéologue Jean-Michel Geneste sur un dataset limité à partir de quelques milliers d’images brutes. Nous les avons sélectionnées et augmentées de manière intelligente. Avec une base de données générique, le résultat aurait été totalement différent.”

Bien que la croyance populaire voudrait que l’IA génère des contenus instantanément (donc qu’elle soit synonyme de gain de temps), il faut préciser que la constitution de ces datasets est une entreprise de longue haleine. “La réalisation des datasets demande du temps. Quand on commence à travailler on pense que c’est plus rapide mais tout est plus long.” prévient Bruno Ribeiro. Et les étapes sont nombreuses : sélectionner les données, prétraitement des données (nettoyage), division du dataset entre données d’entraînement et données de test (contrôle la qualité du modèle), entraînement, réajustement, évaluation, amélioration… “L’entraînement dure quelques heures mais les phases en amont et en aval peuvent durer des mois. Il faut également prendre le temps de visionner des centaines d’images créées. C’est un processus multi couche qui n’est pas instantané, à l’opposé du prompt qui génère une image immédiate.” témoigne Justine Emard.

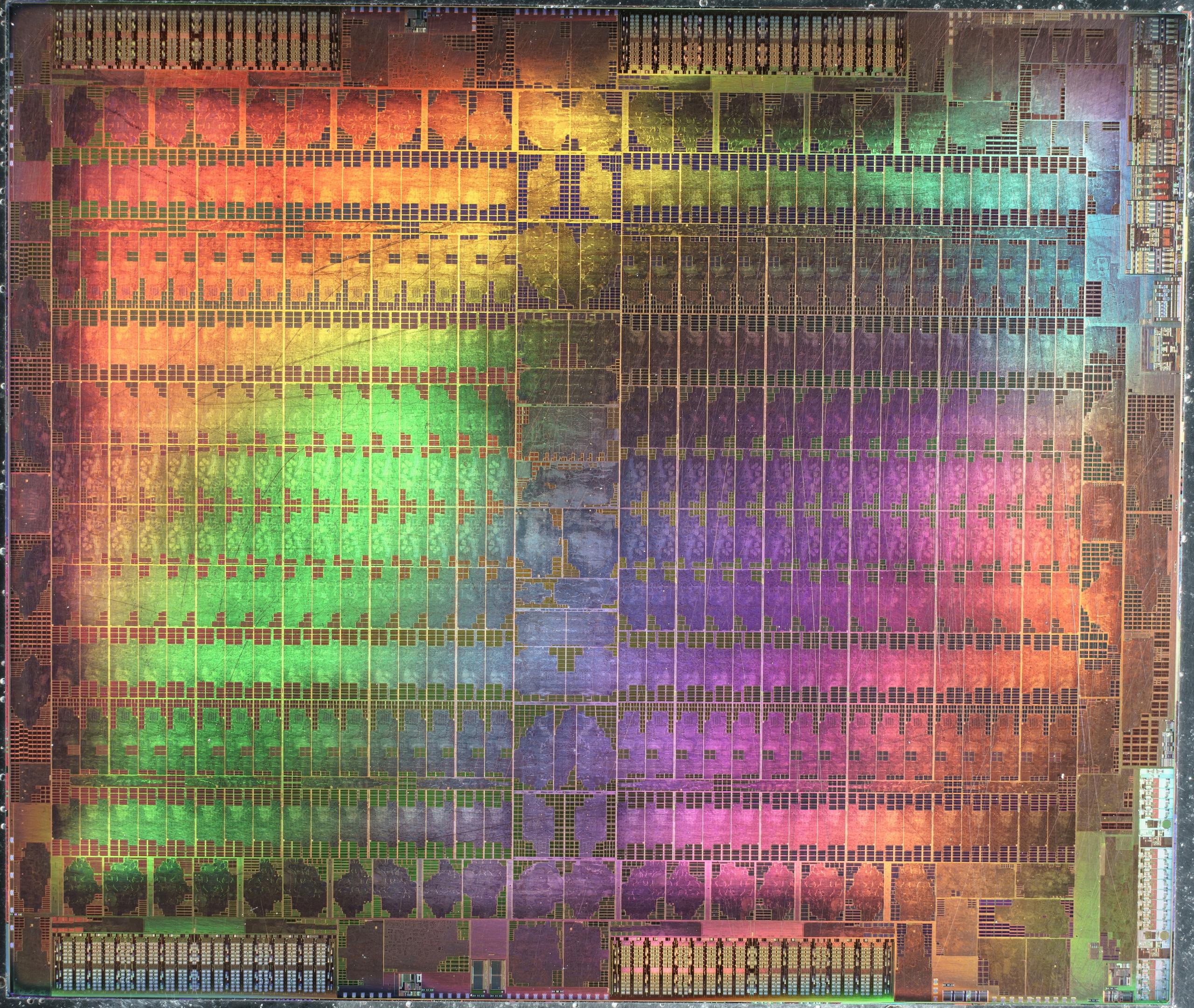

Des impacts écologiques et sociaux

La question du dataset s’examine également sous un angle environnemental et social. Les LLM reposent sur des jeux de données colossaux et nécessitent une puissance de calcul et des ressources considérables. « On en revient à la matérialité du numérique. Les données sont stockées sur des serveurs gigantesques qui ont besoin d’importantes ressources énergétiques. La production d’électricité mais aussi de semi-conducteurs qui implique l’extraction massive de silicium et de terres rares » explique Ismaël Joffroy Chandoutis. Les données sont traitées par des processeurs (GPU) réalisant des calculs d’IA ainsi que des rendus vidéo et graphiques. Un modèle comme ChatGPT sollicite plusieurs centaines de milliers de GPU à chaque entraînement. Bien qu’il n’existe aucune déclaration officielle, plusieurs sources estiment que l’entraînement de GPT-4o a probablement nécessité au moins 25 000 GPU de haute performance pendant plusieurs mois. « Les modèles H100 de Nvidia sont aujourd’hui majoritairement utilisés. Des puces comme celles de Neural Engine (Apple) cherchent à optimiser leur impact en étant plus spécialisées et en se concentrant uniquement sur des calculs de l’IA. Malgré tout, bien que le coût environnemental de ces processeurs baisse, les échelles restent astronomiques » ajoute Ismaël Joffroy Chandoutis.

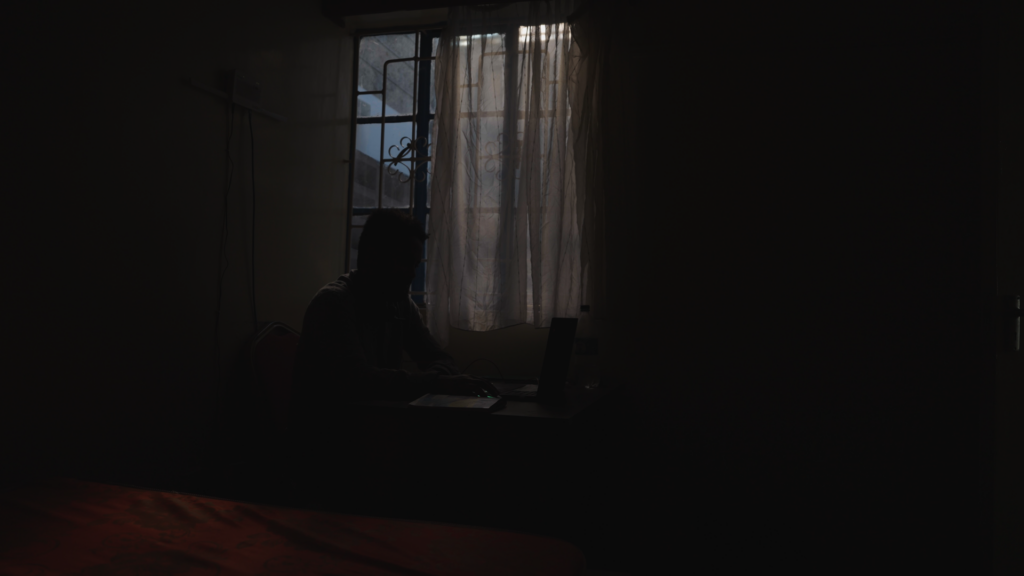

Par ailleurs, il est important de rappeler que de nombreux modèles d’IA, y compris ceux dits non supervisés, sont calibrés grâce à une intervention humaine. Ces « travailleurs du clic », souvent basés à Madagascar ou en Asie du Sud-Est ont pour mission d’ “annoter les textes ou les images, afin de construire le corpus d’apprentissage, par exemple en indiquant sur la photo d’un carrefour quels sont les panneaux de signalisation, ou en identifiant des traces de rouille sur des photos de poteaux électriques, ou en repérant si un client est en train de voler dans un magasin, explique le sociologue Clément Le Ludec dans Le Monde, Même ce que l’on appelle l’IA générative est concernée. ChatGPT a nécessité beaucoup d’annotations pour apprendre au programme ce qui est une réponse acceptable ou non, selon une certaine échelle de valeurs. Dans notre base de données d’entreprises recourant à ces tâches humaines, un tiers appartient au secteur du traitement automatique des langues.” L’œuvre en cours de création Image Latente de Quentin Sombsthay (prix SCAM émergences 2023) retrace justement les troubles de stress post-traumatique de ces travailleur·euses du clic basé·es à Nairobi au Kenya. Payé·es 2$ de l’heure, ils·elles trient manuellement des contenus ultra violents pour mettre au point la censure de ChatGPT.

Entraînement des données en local

Là encore, les artistes peuvent minimiser leur impact environnemental. « C’est une réflexion qui incombe à chacun·e. Ce sont des compromis à faire entre cohérence artistique, ressources financières, et éthique personnelle. Personnellement, j’ai voulu travailler sur un serveur local qui redistribue la chaleur » partage Justine Emard. L’entraînement sur des serveurs locaux est en revanche moins compatible avec des LLM. « Techniquement, c’est possible, mais cela nécessiterait des ordinateurs très puissants, que peu de personnes peuvent s’offrir, pour traiter toutes ces données, sans quoi l’expérience serait dégradée » rappelle Ismaël Joffroy Chandoutis. D’où l’engouement actuel dans le monde de la Tech pour les SLM (Small Language Models). La différence entre un Small Language Model et un Large Language Model réside principalement dans la taille de leur architecture, leurs capacités de calcul et bien sûr, dans la quantité de données d’entraînement. « On s’oriente progressivement vers une cohabitation entre les modèles LLM et SLM. Par exemple, la stratégie d’Apple est de faire tourner leur IA sur les dernières versions des iPhones, donc en mémoire locale et avec peu de watts » ajoute-t-il.

L’entraînement des données peut également être optimisé (finetuning) via la technique des LoRAs (Low Rank Adaptation) qui permet de fine-tuner des modèles de grande taille. Néanmoins, il est bon de se rappeler que les LLM et les générateurs d’images ne sont pas les seuls modèles sur le marché : il existe d’autres modèles moins avancés basés sur le Machine Learning par exemple, et qui peuvent d’autant mieux convenir. Marc Chemillier, directeur d’étude à l’EHESS de Paris, est co-créateur (avec d’autres chercheur·euses de l’IRCAM) de Djazz. “Avec le genre d’IA que nous utilisons, les ressources sont très limitées. Notre modèle n’est pas basé sur le deep learning, c’est un modèle de probabilité de transition. On peut faire des choses impressionnantes avec de faibles quantités de données et peu de matériel. Il suffit d’avoir un micro et un ordinateur. Ensuite le logiciel capte un flux musical et apprend à jouer comme lui. C’est un modèle agnostique donc il n’y a pas de signature rythmique particulière, juste une battue régulière qui organise les données. Les connaissances musicales sont dans le flux qu’on capte, puis l’IA crée une improvisation.”

Les données soumises au droit d’auteur

Enfin, la provenance des données a fait l’objet de vifs échanges sur la question du droit d’auteur. Michal Seta, creative technologist au Lab148 à Montréal, résume le débat : “Il y a plusieurs éléments à analyser : les droits du modèle (lire l’article publié sur HACNUMedia) mais aussi les droits sur les données qui servent à entraîner l’IA et la protection d’une production d’une œuvre générée par l’IA. La question est de savoir d’où viennent les données d’entraînement. Des modèles comme ChatGPT sont entraînés à partir de médias en ligne, de Wikipédia, des contenus publiés sur les réseaux sociaux. Ces grandes entreprises sont complètement opaque sur leur dataset.” De la même manière “Les données envoyées dans ChatGPT sont utilisées pour entraîner OpenAI. Il y a à la fois un problème de confidentialité mais aussi de consentement”. Récemment un article publié dans HACNUMedia, posait la question en ces termes “Les artistes dont le travail a nourri une IA peuvent-ils·elles être considéré·es comme co-auteur·rices ?” Si la récente publication de l’AI ACT tente d’apporter des réponses notamment avec l’obligation pour ces IA génératives de publier un résumé détaillé des sources utilisées pour l’entraînement, il existe peu de marge de manœuvre. Les Watermarks anti IA (information subtilement intégrée dans une image, un texte ou une vidéo et utilisée pour protéger les créations contre l’utilisation non autorisée) ou d’autres projets comme le site HaveIBeenTrained permettant aux artistes de faire retirer leurs images des database de LLM comme Stable Diffusion, sont intéressantes mais ont finalement peu impact. Dans ce jeu du chat et la souris, les artistes font finalement face à une réalité imparable : la data est bel et bien l’or noir du 21e siècle.

Rédaction Adrien Cornelissen

| L’auteur de l’article Au fil de ses expériences, Adrien Cornelissen a développé une expertise sur les problématiques liées à l’innovation et la création numérique. Il a collaboré avec une dizaine de magazines français dont Fisheye Immersive, XRMust, Usbek & Rica, Nectart ou la Revue AS. Il coordonne HACNUMedia qui explore les mutations engendrées par les technologies dans la création contemporaine. Adrien Cornelissen intervient dans des établissements d’enseignement supérieur et des structures de la création. |

Newsletter

Retrouvez tous nos articles directement dans votre boîte mail en vous abonnant gratuitement.